Thèmes : Sciences. Société

Conférence du mardi 16 mars 1982.

Devant une soixantaine de personnes, Monsieur CHAPOUTHIER, docteur es-sciences et docteur en philosophie, chargé de recherche au C.N.R.S., auteur de nombreux travaux sur les bases biologiques de la mémoire et sur la philosophie de la biologie, auteur de livres, en collaboration, sur le problème de l’inné ou de l’acquis, d’articles et en particulier sur « les fraudes biologiques », est venu nous parler de l’intelligence artificielle. Il a tenté de répondre à la question : la machine peut-elle être intelligente à la manière de l’Homme ?

Quelques considérations préalables (Marcel Sire).

1. La question posée est ainsi rédigée :

« La machine peut-elle être intelligente à la manière de l’Homme ? »

question toute différente de celle-ci :

« La machine peut-elle avoir la même intelligence que l’Homme ? »

D’autre part, comme il s’agit de comparer l’intelligence de la machine à celle de l’Homme, on prend cette dernière comme étalon de référence ; on pourrait s’adresser à tout autre système, animal, mécanique ou purement mathématique.

Prendre l’intelligence de l’homme comme étalon ne nous oblige d’ailleurs pas à la considérer comme la limite supérieure du comportement intelligent.

2. Mais qu’est l’intelligence ?

La définition est difficile, surtout si l’on considère qu’il ne s’agit pas d’une qualité propre aux conduites humaines.

Il semble que l’on puisse dire (selon Monsieur Paul Trouillas, professeur agrégé à l’Université Claude Bernard de Lyon), que l’intelligence biologique observée chez les Primates et l’Homme soit :

- la capacité d’établir un lien logique à partir de formes, de situations, de données,

- et la capacité de donner une réponse adaptée à l’aide de cette logique découverte.

Elle n’est donc pas la seule connaissance, la seule mémoire, et sans doute pas le génie.

Alors que la mémoire consiste seulement en la fixation d’informations (et là les ordinateurs actuels battent l’Homme), l’intelligence est une forme de traitement de l’Information.

Aussi était-il indiqué que Monsieur CHAPOUTHIER commence son exposé par quelques propos sur l’information.

I. L’INFORMATION.

Étymologiquement « informer » c’est mettre des données en forme.

Ce terme recouvre, d’après Monsieur CHAPOUTHIER, trois définitions liées entre elles :

- sens familier : L’information dans ce cas est liée à une notion de signification. Elle a un sens pour celui qui la reçoit.

Exemple : le journal me donne une information élaborée par le journaliste.

- sens technologique : L’information devient une grandeur « aveugle ». C’est un ensemble de paramètres qui permet de définir un message.

- sens scientifique : L’information est un ensemble de données qui permet de décrire tout objet du monde.

Les théoriciens de l’information, du fait de la dégradation de celle-ci, la rattachent à la notion d’entropie.

II. L’ÊTRE VIVANT.

- Il peut se définir à partir de l’information scientifique ; l’information génétique définit l’être vivant, son espèce, certains de ses caractères.

- Il est aussi caractérisé par son organisation, sa structure organique (organes, cellules…) et sa structure fonctionnelle.

- Donc à un certain contenu en information est liée une structure :

- ayant une caractéristique de totalité qui le rend plus ou moins indépendant de l’environnement,

- présentant des transformations qui conduisent éventuellement à son évolution ;

- ayant un auto réglage.

- Il subit une évolution permanente (fœtus, embryon … adulte). Il peut se reproduire.

Pendant longtemps, seuls les êtres vivants avaient ces propriétés.

La construction par l’homme de machines qui travaillent avec de l’information et qui ont, certaines, mêmes caractéristiques a changé bien des choses : certaines machines ont une structure ; elles évoluent, elles sont susceptibles d’un autoréglage … comme des êtres vivants.

Il semble que l’Homme ait tout d’abord conçu des machines pour l’aider dans ses calculs ; dans ce domaine limité, les machines apportant leur « intelligence » à l’Homme furent les machines à calculer … puis les ordinateurs.

III. LES MACHINES A CALCULER ET LES ORDINATEURS.

1. Historique.

Les machines à calculer sont de deux types :

- mécaniques,

- électroniques.

Mécaniques :

- le boulier compteur, apparu en Chine il y a plus de 2000 ans, encore employé dans certaines régions d’Europe et d’Asie. On y trouve la fonction mémoire.

- Les bâtons de Neper (1617) qui crée une règle d’ivoire graduée, ancêtre de la règle à calcul qui permet les multiplications.

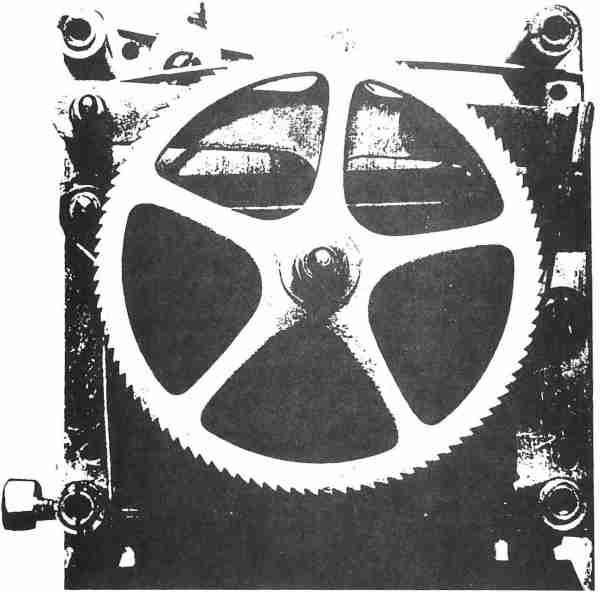

- Pascal qui, pour soulager son père dans les calculs que lui imposait sa charge d’Intendant des Finances, construit en 1642 (il avait 19 ans) la Pascaline, machine à calculer, avec des engrenages, avec les fonctions mémoire et report automatique.

- Leibniz, en 1694, dresse les plans d’une calculatrice capable de multiplier et de diviser. Il cherche à mécaniser le calcul des tables trigonométriques et astronomiques.

- Les machines de Babbage ; en 1822, il matérialise un projet de machine à calculer les tables trigonométriques jusqu’à la 6ème décimale ; puis une autre, jamais réalisée, qui poussait les calculs jusqu’à la 20ème décimale ; puis une autre avec introduction des données, instructions, mémoire, sorties, imprimante. C’était déjà le schéma fondamental de nos ordinateurs ; mais la machine, trop compliquée pour l’époque ne fut pas construite. Babbage qualifiait sa machine de « machine analytique ».

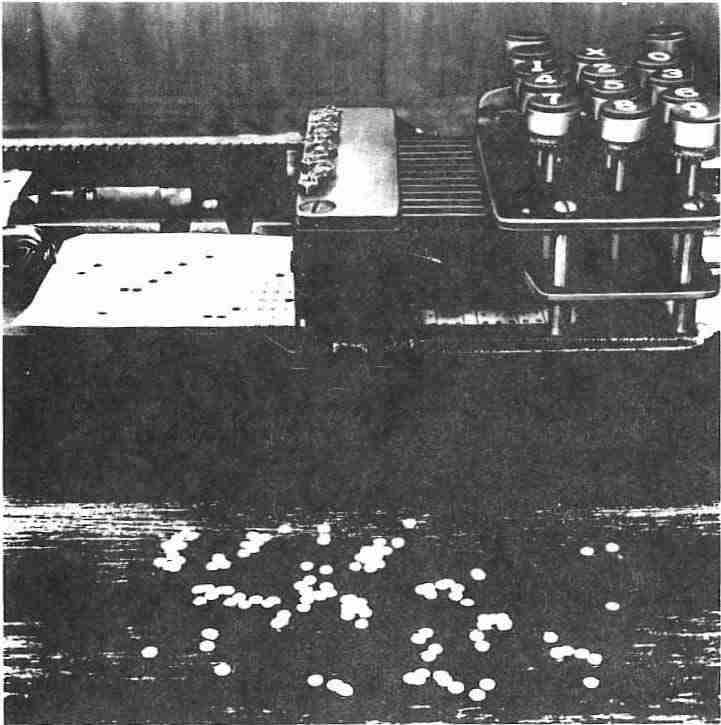

- Puis vint le grand moment du docteur Herman Hollerith ; le statisticien américain, Herman Hollerith, chargé en 1890 du recensement de la population des Etats-Unis, mariait ingénieusement l’électricité, la mécanique des roues totalisatrices et la technique de la carte perforée déjà connue et utilisée dès la fin du XVIIIe siècle pour la conduite automatique des métiers à tisser (fig. 1,2,3). Le passage du courant au travers d’une perforation faisait avancer d’un cran un totalisateur. Ce fut incontestablement une révolution : celle de la machine à calculer. L’invention d’Hollerith fut vite industrialisée. Mais ce n’était pas pour autant l’avènement de l’ordinateur. La machine d’Hollerith était en effet infidèle sur un point capital de la philosophie de Babbage : le programme des opérations était incorporé de façon fixe, sous la forme d’un tableau de connexions électriques.

La fixité matérielle du programme contrevenait au principe d’universalité ; la machine d’Hollerith était limitée à un ensemble de fonctions matérielles immuables. Il n’empêche que le recensement de la population en 1890 se fit deux fois plus vite que celui de 1880.

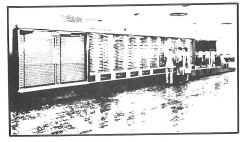

- 1944, le docteur Howard Aiken réalise « Mark 1 », gigantesque calculatrice électromécanique qui n’est qu’une machine de bureau, mais entièrement automatisée (fig. 4).

L’énorme appareil de 5 tonnes était constitué de 78 éléments reliés entre eux par 800 km de câbles électriques et utilisait 3304 relais mécaniques Mark 1 pouvait multiplier 2 nombres de 23 digits (caractères) en 6 secondes. Mais la machine fut rapidement abandonnée.

Première génération des ordinateurs électroniques :

Avec l’électronique, c’est un accroissement fantastique des vitesses de traitement.

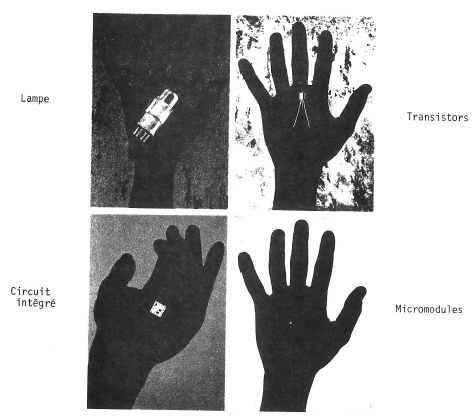

En 1946, le remplacement des éléments électromécaniques par des lampes et tubes à vide (fig. 5) constitue un tournant décisif de l’histoire informatique.

Fig. 1

Fig. 2. La machine d’Herman Hollerith ou l’apparition de la carte perforée (fig. 3)

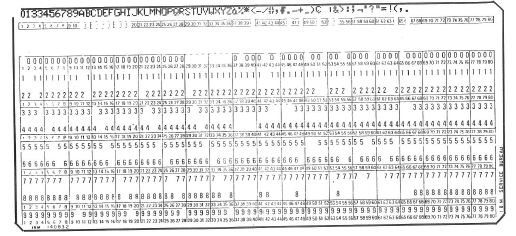

Fig. 3. La carte perforée actuelle avec ses 80 colonnes.

Fig. 4. Mark 1 : premier calculateur numérique automatique à grande puissance

Fig. 5. Ordinateurs à lampes et tubes à vide.

Entre 1946 et 1952, les premières calculatrices entièrement électroniques font leur apparition (ENIAC en 1946 (1) et EDUAC (2) en 1952 créée par Von Neumann). Lampes et commutateurs y remplacent les anciens compteurs et relais. La multiplication de 2 nombres de 10 digits peut être dès lors réalisée en 1/40 seconde … et en 1953, après d’autres améliorations technologiques, en 1/2000 seconde.

(1) -ENIAC : electronic numerical integrator et computer. surface : 170 m – consommation : 200 KW. puissance de calcul : celle d’une calculette de poche d’aujourd’hui.

(2) -EDUAC de Von Neuman, peut recevoir en mémoire des instructions de traitement (= programme). On peut donc modifier sur commande ces instructions.

Histoire du stockage de l’information :

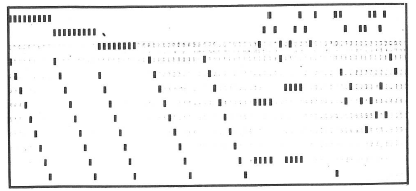

La carte perforée (fig. 6) fut un des premiers supports physiques pour l’enregistrement des données.

Mais au début des années 50, sont mises au point, pour le stockage de forts volumes de données, des mémoires dites de masse. Ces mémoires, bandes et tambours magnétiques ont des capacités très supérieures et permettent d’accéder aux données dans des temps beaucoup plus courts.

1956 : c’est l’apparition des premiers disques magnétiques qui, assemblés en groupes, permettent des capacités de stockage de plusieurs millions de caractères.

Dès 1954, les mémoires centrales à tores de ferrite évincent définitivement les lentes mémoires à tambours des premiers calculateurs.

Fig. 6. La carte perforée à 80 colonnes. Le plus ancien des supports de l’information

Elle permet d’enregistrer jusqu’à 80 caractères

Avec les transistors, une deuxième génération d’ordinateurs :

1959 : le contrôle du déplacement des électrons dans l’état solide a permis de mettre au point des transistors qui vont donner naissance à une nouvelle génération d’ordinateurs

Les ordinateurs à transistors peuvent multiplier 2 nombres de 10 digits en 1/100 000 de seconde.

C’est véritablement dans les années 60 que l’utilisation des ordinateurs peut être généralisée, en particulier grâce à l’apparition des machines à transistors beaucoup plus puissantes, plus fiables et moins coûteuses.

L’impression des résultats :

A mesure qu’augmentent les vitesses de calcul, augmentent les vitesses d’impression. En 1959 les imprimantes à chaines réalisent aux environs de 600 lignes à la minute.

En 1963, grâce au montage des caractères sur un ruban d’acier, la vitesse d’impression passe à 1100 lignes par minute. Une vitesse multipliée par 6 avec, en 1975, les nouvel les imprimantes à système d’impression électrophotographique qui utilisent le laser.

1962 : l’avènement des circuits intégrés, et la 3ème génération.

Ils vont peu à peu devenir les composants uniques de l’ordinateur, à la fois technologie de calcul et de mémorisation. Désormais transistors, diodes et résistances sont intégrés sur un seul module. Cette nouvelle technologie permet aux ordinateurs de réaliser plusieurs millions de calculs à la seconde.

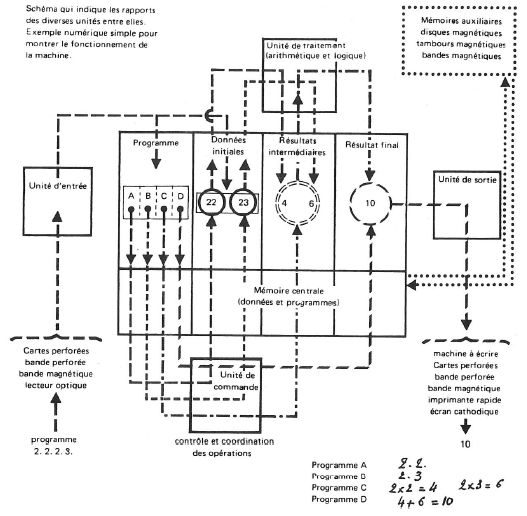

2. Structure des ordinateurs.

Un certain nombre de fonctions doivent obligatoirement être présentes dans la structure d’un ordinateur

- une fonction calcul et traitement réalisée par l’unité arithmétique et logique (U.A.L.)

- une fonction mémorisation (mémoire centrale, mémoires auxiliaires, mémoire de masse).

- une fonction d’entrée et une fonction de sortie des données dans la machine qui permettent les relations avec l’extérieur.

- une fonction contrôle qui émet des ordres, qui gère les transferts de données et le déroulement du programme. On aboutit ainsi au schéma général suivant (fig. 7).

Fig. 7. L’opération à effectuer est (2 x 2) + (2 x 3).

On introduit dans l’unité d’entrée un programme (carte perforée) pour le programme à suivre, qui est mémorisé dans les cellules A, B, C, D.

Les valeurs 2.2.2.3. sont mémorisées ailleurs dans la mémoire, 2.2. par A, 2.3. par B, comme données initiales.

La cellule C va commander l’opération 2 x 2 = 4, et l’opération 2 x 3 =6, 4 et 6 étant placés dans la mémoire.

La cellule D commande l’opération finale 4 + 6 =10 qui est livré à l’unité de sortie.

Donc au total : unité d’entrée, mémoire, unité de commande, unité de traitement, unité de sortie.

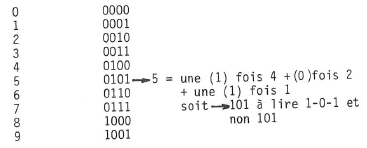

3. L’alphabet de l’ordinateur.

C’est le code binaire, une convention qui eut un précédent célèbre : l’alphabet Morse, le premier à utiliser l’électricité à la fois comme support et symbole de communication.

Dans un ordinateur, on ne fait pas varier la durée d’émission du signal ; on fait passer ou non un courant, une impulsion. De même qu’une ampoule électrique peut être allumée ou éteinte, de même un circuit électrique peut être conducteur ou bloqué. Le code physique de l’ordinateur se résume ces deux états qui représentent les valeurs 0 et 1.

Dans la communication humaine écrite, les caractères de l’alphabet, les chiffres tiennent lieu de signes. En ordinateur, chacun de ces caractères ou signes est représenté par une suite de signes binaires : 0 et 1 ; ce qui permet de représenter n’importe quel nombre, les 27 lettres de l’alphabet et l’ensemble des signes de ponctuations traditionnels.

Un tel système facilite considérablement la conception et la fabrication des circuits électroniques. Les deux valeurs 0 et 1 permettent de coder tout message. La mémoire de l’ordinateur ne connaît que cette seule représentation.

Par contre les messages adressés l’ordinateur seront rédigés à l’aide de l’alphabet et du système de numération décimale (programmes).

Les programmes, méthodes de traitement, algorithmes …, sont appelés outils « logiciel » ou « software » ; les machines, circuits électroniques … sont appelés outils « matériels » ou « hardware ».

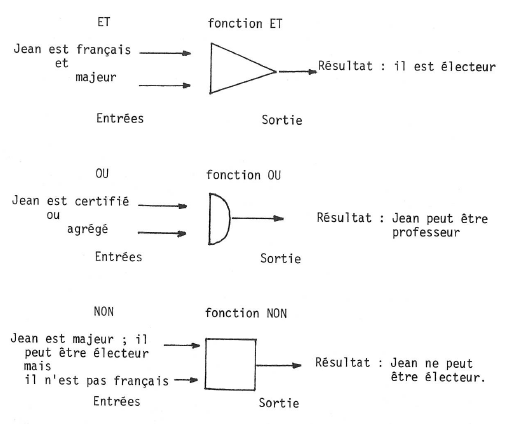

4. Fonctions logiques : elles se réduisent trois ET – OU – NON (flg. 8).

Fig. 8. Les trois fonctions logiques ET – OU – NON qui permettent les opérations arithmétiques.

5. De quelle manière les machines peuvent-elles simuler l’intelligence ?

Il faut bien faire la distinction entre : algorithme et heuristique. L’algorithme est l’exploitation systématique des possibilités d’un problème. L’ordinateur exécute les algorithmes plus rapidement que l’homme.

L’homme, lorsqu’il se trouve devant un problème, n’a pas le temps d’étudier tous les cas de figure, en tout cas consciemment.

Il résout le problème par heuristique (science de la recherche des faits), c’est à dire qu’il cherche une méthode qui lui permette d’aller plus vite pour trouver le résultat.

L’homme utilise un procédé qui n’est pas toujours systématique.

Pas question d’appeler « intelligentes » des machines qui ne font qu’appliquer les formules qu’on leur a enseignées même si elles le font plus rapidement que nous. Mais les choses se compliquent lorsque l’on considère les ordinateurs dotés de programmes de reconnaissance des structures, de simulation de fonction s logiques, de traduction, de découverte de théories mathématiques et de jeux complexes.

a). Reconnaissance des structures :

Programme MAUD.

Il décode le Morse. Ce travail est facile pour l’homme car même si par exemple des signaux longs n’ont pas tous la même durée, si les intervalles entre signaux ne sont pas très constants, l’homme fait très aisément la reconnaissance et sait quand même reconnaître un signal long d’un court. Il lit donc le message. Qu’en est-il de l’ordinateur ?

Grâce au programme Maud, il est capable d’effectuer ce travail.

Il mesure la durée des signaux et des intervalles entre signaux.

Il fait des découpages pour trouver les lettres … et finit par trouver le message. C’est un procédé systématique donc algorithmique qui est différent de la méthode utilisée par notre cerveau qui pour décoder un message en Morse, par exemple, ne va pas comparer tous les signaux pour les trier …

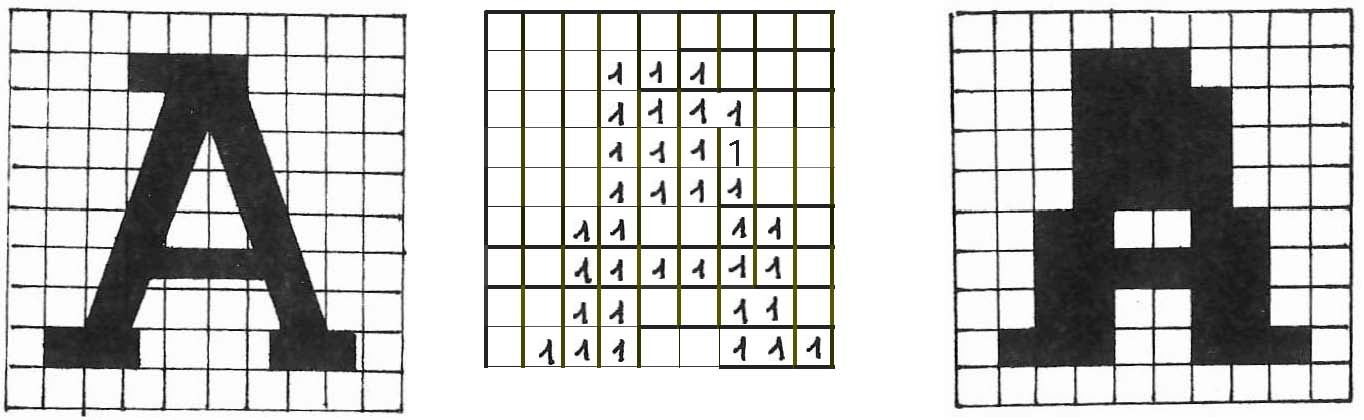

Programme de lecture de lettres écrites à la main.

Une lettre écrite à la main est parfois déformée. L’homme la reconnaît en s’aidant du contexte, en lisant le mot.

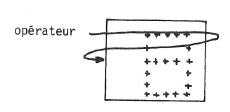

L’ordinateur doit « voir » la lettre. Pour cela, on la projette sur un écran comportant des cellules photoélectriques. Lorsque la cellule est excitée, on aura information 0 ; dans le cas contraire, une information 1. L’ordinateur « voit » la lettre comme une matrice de 1 et de 0. Il rectifie ensuite la lettre. Puis il utilise la méthode des détails significatifs (est-ce que la lettre est plus longue que large ? Combien de fois est-elle coupée par une horizontale, une verticale …). En mémoire il a une liste. Si la lettre présente tel ou tel détail, il sait que cette lettre peut être soit A soit B par exemple. Il continue ainsi son travail en faisant la somme des probabilités (fig. g). Il existe une autre méthode. L’ordinateur travaille sur des sous matrices et fait coïncider les opérateurs avec la lettre (fig. 10).

Reconnaissance de la voix.

Dans ce domaine les résultats sont encore modestes. L’ordinateur reconnaît très bien le timbre de la voix, mais il ne reconnaît pas les mots prononcés par des personnes différentes ; par contre il peut reconnaître certains mots prononcés par la même personne.

b. Simulation des fonctions logiques.

Ces programmes ont un catalogue de mots en mémoire avec leurs significations … Il est capable de dire que le Tigre est un animal, mais en outre un Mammifère, un Carnivore.

Fig. 9. Comment l’ordinateur lit les lettres, ici la lettre « A »

La lettre A est découpée en petits carrés, 100 dans le schéma 1 ; une cellule photoélectrique détecte la présence de noir dans chacun des carrés, et enregistre 1 dans la mémoire et 0 dans les carrés blancs.

C’est ce que représente le schéma 2 (dans lequel, pour plus de clarté nous n’avons pas figuré les 0).

La machine compare le résultat (schéma 3) avec un répertoire de formes stockées dans sa mémoire ; elle choisit la forme la plus proche.

Dans le cas présent, elle pourrait hésiter entre A et H, et, avec les autres lettres du mot, écrire :

- soit MACHINE

- soit MHCHINE

Un Français, grâce aux autres lettres d’un mot qu’il connaît,

- lira MACHINE

- puisque MHCHINE n’existe pas dans sa langue.

Fig. 10

c. Programmes de traduction automatique :

Grâce à des programmes complexes d’analyse morphologique de chaque phrase, on a mis au point des logiciels comme le projet Taum qui sait traduire, d’anglais en français, les bulletins météorologiques, comme le programme System utilisé par la Communauté européenne pour traduire toujours d’anglais en français, des textes spécialisés. Peut-on appeler intelligentes de telles machines capables d’effectuer un travail au-dessus de la capacité de bon nombre de personnes, mais bien incapables de traduire des textes de Proust ou de Stendhal ? Car dans ces cas-là, la compréhension du contexte est importante et des contresens peuvent être nombreux.

Exemple : Traduire la phrase anglaise : « Times flies like an arrow ».

Time peut être un nom : temps ; ou un verbe chronométrez. Like veut dire « comme » ou « aimer » Flies veut dire « mouches » ou « voler » (fly)

Quatre interprétations possibles :

- Le temps se déplace en vol comme une flèche.

- Chronométrez les mouches comme vous chronométrez une flèche.

- Chronométrez les mouches qui ressemblent à une flèche.

- Les mouches du temps ressemblent à une flèche.

Une seule traduction correcte est : « le temps passe comme une flèche » ; traduction voisine de la première.

d. Résolution de théorèmes mathématiques :

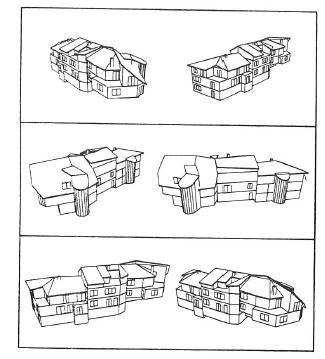

Il existe toute une série de programmes permettant de résoudre des théorèmes mathématiques ou d’étudier des volumes.

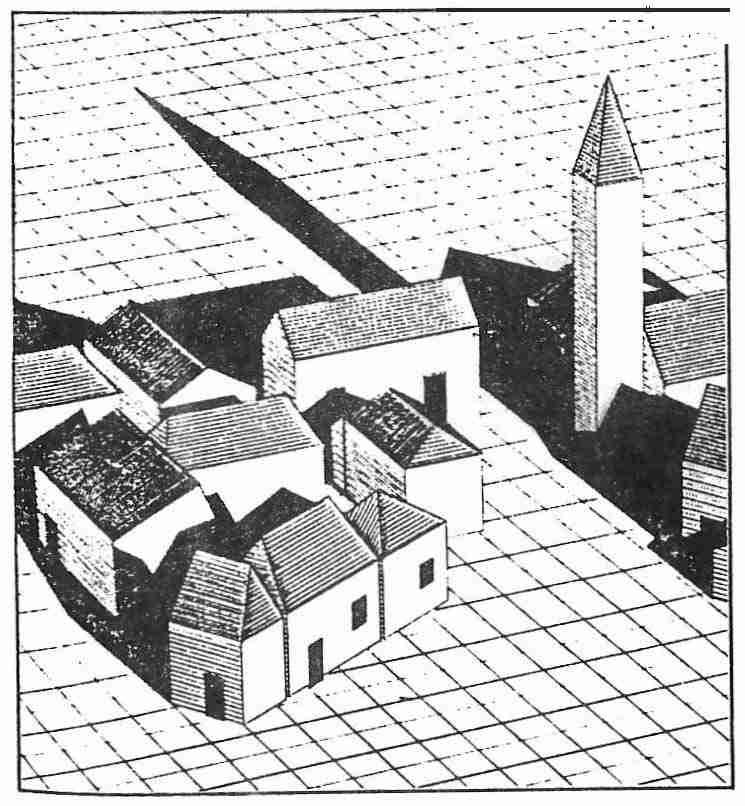

La figure 11 nous montre l’étude des effets de la maquette d’un immeuble selon les différentes positions de « l’œil » d’un ordinateur, et la figure 12 la visualisation volumes avec l’étude de l’ombre portée.

e. Jeux complexes :

Il existe des programmes qui permettent de battre aux échecs les meilleurs joueurs mondiaux. Chess 4,9 par exemple, mis au point par David J. Slade et Lawrence Atkin de l’Université Northwestern, a battu l’an dernier un excellent joueur américain Paul Benjamin. Mais Chess 4,9 n’arrive pas à la hauteur d’un Bobby Fisher. Le programme ne peut posséder en mémoire toutes les stratégies, toutes les possibilités.

Fig. 11. Étude des effets de la maquette d’un immeuble selon les différentes positions de « l’œil » d’un ordinateur. LIMSI.

Fig. 12. Visualisations de volumes avec étude de l’ombre portée.

LETUAN PHAC – Jean-Louis DAHAN.

6. Rapport entre l’ordinateur et l’être vivant.

Qu’y a-t-il de commun entre tous ces programmes, ces machines auxquelles on a attribué, un peu à la légère, cette qualité suprême de l’homme qu’est l’intelligence ?

Deux choses fondamentales les distinguent de l’homme :

- la reproduction : l’ordinateur ne peut fabriquer lui-même un système analogue à lui.

- l’évolution des programmes : il n’apprend que ce que le programmeur lui donne. De plus, aucun de ces programmes d’ordinateur, d’une complexité déjà très grande, ne peut à la fois le faire jouer honorablement aux échecs, lire Faulkner … Ces machines sont ultraspécialisées.

7. Projets futurs (fig. 13).

Une nouvelle technologie de mémorisation, les bulles magnétiques, qui quittent désormais le stade de la recherche, peuvent accroître considérablement les densités de stockage en mémoire centrale. Ces bulles sont de minuscules régions magnétisées, que l’on trouve dans certains pays de matériaux magnétiques extrêmement fins.

On peut également fonder des espoirs sur les recherches relatives aux mémoires optiques, holographiques, ou encore utilisant le principe de la supraconductivité.

On expérimente également un dispositif électronique qui permet de passer d’une position à une autre en moins de 10 picosecondes (10-12 secondes).

Des procédés de fabrication courante des micromodules utilisent des rayons ultraviolets pour le dessin des lignes de circuits.

Cette technique permettrait d’imprimer le contenu intégral de la Bible sur une surface de 10 cm2 ; actuellement un nouveau système est étudié pour remplacer les rayons lumineux par un faisceau d’électrons. Avec ce procédé on pourrait imprimer un livre entier sur un carré de 3mm de côté.

Enfin les japonais font des recherches pour avoir des ordinateurs « pipe line », branchés les uns aux autres. La puissance actuelle des ordinateurs serait ainsi multipliée par 1000.

Ils veulent développer la traduction automatique et le langage de la parole ; ils ont lancé un « pari » pour 1990-1995.

Peut-on imaginer qu’un jour un ordinateur se reproduirait et acquerrait dans son environnement qu’il explorerait, lui-même et seul, des informations ?

Fig. 13.

Monsieur CHAPOUTHIER pense qu’avec les techniques actuelles c’est impossible. Il faudrait construire des ordinateurs sur des bases biologiques et non électroniques.

Monsieur CHAPOUTHIER fut vivement applaudi.

Découvrez + de 1100 textes des conférences du CDI sur le site du CDI de Garches

Vos commentaires et vos conseils contribuent à l’amélioration de nos parutions.

Vous disposez de l’espace « COMMENTAIRES » ci-dessous pour les exprimer.

Merci et à bientôt pour votre prochaine visite.

Laisser un commentaire